Gobernantes que aconsejan inversiones, candidatos que se drogan y alienígenas ancestrales: las desinformaciones con inteligencia artificial en TikTok

- Con el avance de la inteligencia artificial, existen cada vez más herramientas que permiten generar imágenes, manipular videos e imitar voces de formas que pueden resultar prácticamente indistinguibles de contenidos basados en el registro visual o sonoro.

- En TikTok suelen circular videos generados con esta tecnología para promocionar productos y deepfakes para influir de forma negativa en la imagen de candidatos durante un período electoral.

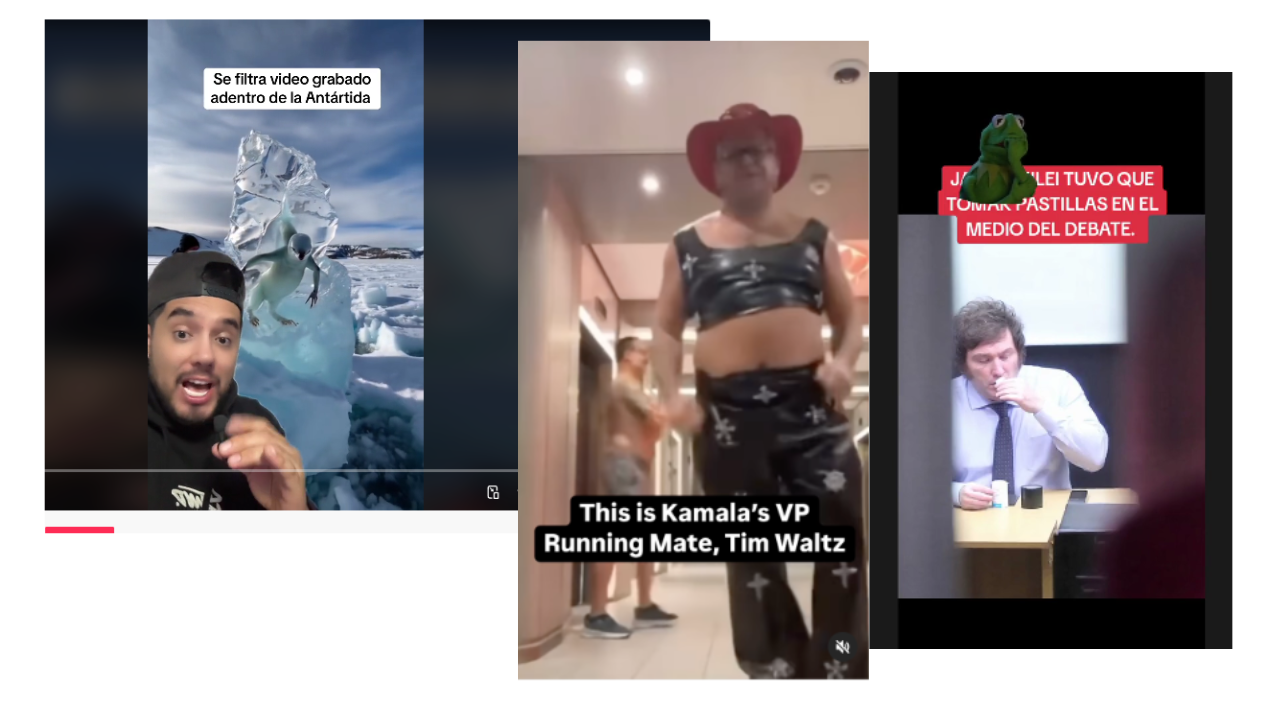

- También suelen circular piezas que sirven de sustento de teorías conspirativas, como videos virales que presentan a la Antártida como un territorio poblado de extrañas criaturas congeladas o, incluso, dinosaurios.

Con la masificación de la inteligencia artificial (IA) generativa, existen cada vez más herramientas que permiten generar imágenes, manipular videos e imitar voces de formas que pueden resultar prácticamente indistinguibles de contenidos basados en el registro visual o sonoro.

Mientras que los avances de la inteligencia artificial abren la puerta a múltiples beneficios, tales como el ahorro de tiempo en tareas repetitivas o la generación de herramientas pedagógicas, también pueden ser utilizados para la producción de contenidos desinformantes cada vez más sofisticados.

En esta nota, un repaso por 3 tipos de desinformaciones usuales en TikTok hechas con esta tecnología y potencialmente de alto impacto, y algunos consejos para no caer en un engaño de este tipo.

Videos generados con inteligencia artificial para promocionar productos

El 26 de abril de 2024, en su habitual conferencia de prensa matutina, el entonces presidente de México Andrés Manuel López Obrador advirtió sobre un contenido que circulaba en redes sociales -entre ellas TikTok- con fines fraudulentos: un video falso en el cual, según parecía, el mandatario recomendaba invertir en la empresa Petróleos Mexicanos (PEMEX). La recomendación, sin embargo, había sido generada con inteligencia artificial: a pesar de que la imagen y la voz del video correspondían a las del ex mandatario mexicano, estas no eran verdaderas (1)(2).

Un contenido similar había circulado meses antes, en enero, en relación con Claudia Scheinbaum –actual presidenta de México y entonces jefa de Gobierno de la Ciudad de México– quien también desmintió recomendaciones de inversión que llevaban su imagen (1)(2)(3). En los videos deepfake se usaba su imagen para invitar a los mexicanos a invertir en una fraudulenta plataforma financiera.

Al utilizar la imagen y la voz de figuras públicamente conocidas, estos contenidos apuntan a revestir de confiabilidad a productos que son ajenos a las mismas. Los servicios y bienes promocionados pueden, incluso, ser estafas.

Por otra parte, los productos promocionados pueden variar. Así, en TikTok existen algunas cuentas (1)(2) que utilizan la voz del ex presidente de los Estados Unidos Donald Trump (Partido Republicano) para difundir mensajes de autoayuda. Al imitar a una figura de significativa popularidad, estos contenidos alcanzan una mayor circulación.

En 2022, circuló también un video manipulado en el que parecía que el propietario de X y director general de Tesla, Elon Musk, estaba promocionando una plataforma de criptomonedas. En la región también tocó el turno de la cantante Shakira, cuya identidad fue utilizada en mayo de este año para invitar a un supuesto proyecto de inversión.

Para identificar este tipo de desinformaciones es importante siempre verificar las fuentes. La constatación de si los contenidos promocionados están presentes en los canales de comunicación oficiales de la persona o institución aparentemente involucrada permite prevenir posibles estafas.

Deepfakes para influir de forma negativa en la imagen de un candidato

Existen otros contenidos desinformantes elaborados con inteligencia artificial que, especialmente en contextos electorales, apuntan a influir negativamente en la imagen de políticos. Frecuentemente, estos son presentados como filtraciones ligadas a la vida privada de los candidatos, en las que estos aparentemente desarrollan acciones ilegales o percibidas como censurables por sectores significativos de la población.

En la campaña presidencial de 2023, circuló en TikTok una imagen falsa del entonces candidato presidencial Javier Milei en la que parecía estar tomando un medicamento antes del tercer debate presidencial. Pero ciertos elementos de la imagen daban cuenta de que no fue tomada en ese contexto, y ciertos signos sugerían que pudo haber sido creada con inteligencia artificial.

Contenidos similares han sido desplegados en el marco de la campaña presidencial en curso en los Estados Unidos. En ese sentido, en agosto de este año circuló viralmente un video en el que se veía a quien parecía ser el candidato a vicepresidente del Partido Demócrata, Tim Walz, bailando vestido de cowboy.

Este contenido fue desmentido por AFP Factual, evidenciando que se trataba de un video del bailarín y artista ‘drag’ Matthew Krumpe, cuyo rostro había sido reemplazado por el de Walz. Según explicó también USA Today, el video se trataba de un deepfake en el que se incorporó la cara de Walz al video real de un bailarín.

Sustento de teorías conspirativas

Al navegar en TikTok también es común encontrar publicaciones que hacen énfasis en supuestos misterios de carácter paranormal. Aunque muchas de estas narrativas no son novedosas en sí, el desarrollo de la IA facilita la elaboración de videos que parecen dar sustento testimonial a las mismas.

En ese sentido, por ejemplo, existen múltiples contenidos enfocados en la Antártida. Así, algunos videos virales presentan al continente blanco como un territorio poblado de extrañas criaturas congeladas o, incluso, dinosaurios. Estos contenidos (1)(2) fueron generados con inteligencia artificial, lo que puede notarse en inconsistencias en los movimientos de las figuras y la proyección de sombras.

Además, en muchos casos los contenidos en esa plataforma tienen una etiqueta en la que se aclara que el contenido fue “generado con IA” (1).

A la vez, también existen diversos contenidos, algunos de ellos generados con IA, que presentan aparentes hallazgos arqueológicos. Entre estos, existen publicaciones que hacen hincapié en la supuesta presencia alienígena (1) o de gigantes (2) en la Tierra en el pasado.

Cómo identificar contenidos hechos con inteligencia artificial

Existen herramientas y prácticas que permiten identificar y contrarrestar estas desinformaciones. Específicamente en lo relacionado a los videos e imágenes generadas con inteligencia artificial, es importante buscar las fuentes de los contenidos, atender a los detalles y observar atentamente el contexto de lo que se muestra, que al ser generado por IA tiende a presentar inconsistencias.

A su vez, siempre es indispensable realizar una lectura crítica de los contenidos. En ese sentido, por ejemplo, ante imágenes de supuestos sucesos es pertinente preguntarse dónde y cuándo se produjeron los mismos, y quiénes son efectivamente los protagonistas de los mismos. A partir de las respuestas a dichas preguntas es posible verificar si las afirmaciones de las publicaciones tienen asidero o carecen de respaldo.

Es útil buscar la fuente de la supuesta foto y averiguar si fue publicada previamente. También es importante mirar las manos, los ojos y los pequeños detalles de contexto para encontrar imperfecciones o marcas. Se pueden usar herramientas de detección automática, aunque no son 100% infalibles.

Fecha de publicación original: 23/10/2024

Comentarios

Valoramos mucho la opinión de nuestra comunidad de lectores y siempre estamos a favor del debate y del intercambio. Por eso es importante para nosotros generar un espacio de respeto y cuidado, por lo que por favor tené en cuenta que no publicaremos comentarios con insultos, agresiones o mensajes de odio, desinformaciones que pudieran resultar peligrosas para otros, información personal, o promoción o venta de productos.

Muchas gracias