Videos generados con Sora 2 desinforman y acumulan más de 40 millones de visualizaciones en TikTok

- Una investigación de Aos Fatos identificó 64 videos hechos con Sora 2; de ellos, 26 contienen desinformación y suman más de 40 millones de visualizaciones.

- La nueva versión de la herramienta de OpenAI puede producir contenidos altamente realistas, lo que amplía su potencial para desinformar en situaciones de crisis.

- Especialistas advierten que la popularización de este tipo de videos puede generar confusión entre usuarios y remarcan la necesidad de discutir la transparencia en el uso de la IA.

Días después de que un tornado causara seis muertes en Rio Bonito do Iguaçu (Paraná), comenzaron a circular en las redes, junto con registros reales del fenómeno, imágenes ultrarrealistas generadas por inteligencia artificial. Al menos cinco de esos contenidos engañosos —que suman casi 6 millones de visualizaciones— fueron creados con la herramienta Sora 2, lanzada por OpenAI a fines de septiembre.

Una investigación de Aos Fatos verificó que cuatro de cada diez videos virales generados con Sora 2 en TikTok difundían desinformación sobre desastres, política, seguridad pública o reproducían prejuicios.

Desde el 30 de septiembre —cuando la herramienta se lanzó— Aos Fatos identificó 64 videos virales creados con Sora 2 que, en conjunto, acumulan 262 millones de visualizaciones en la plataforma. De ese total, 26 publicaciones contenían algún tipo de desinformación y sumaron 41 millones de visualizaciones.

Aún en fase de liberación gradual, Sora 2 permite crear videos cada vez más realistas de manera simple, rápida y barata, ampliando la posibilidad de desinformación a gran escala en situaciones de crisis.

Explotación de desastres naturales

Tras el desastre climático que afectó a Rio Bonito do Iguaçu a principios de mes, comenzaron a circular en redes sociales videos generados por IA que supuestamente registraban “el momento exacto” del paso del tornado. Un ejemplo es el contenido que aparece abajo, que incluye la marca de agua de Sora 2.

Otras publicaciones muestran deslizamientos de casas y calles destruidas por supuestas inundaciones. Las piezas se viralizaron en medio de las alertas por ciclones tropicales que afectaron al país en los primeros días de noviembre.

En los comentarios de uno de los posts más populares —con más de 10 millones de visualizaciones— los usuarios se dividen entre la preocupación y la duda sobre la veracidad de las imágenes.

Megaoperativo policial

En las últimas semanas también se viralizaron supuestos registros del megaoperativo policial realizado en los complejos del Alemão y de la Penha, en Río de Janeiro. Parte de los materiales verificados por Aos Fatos fue generada con Sora 2.

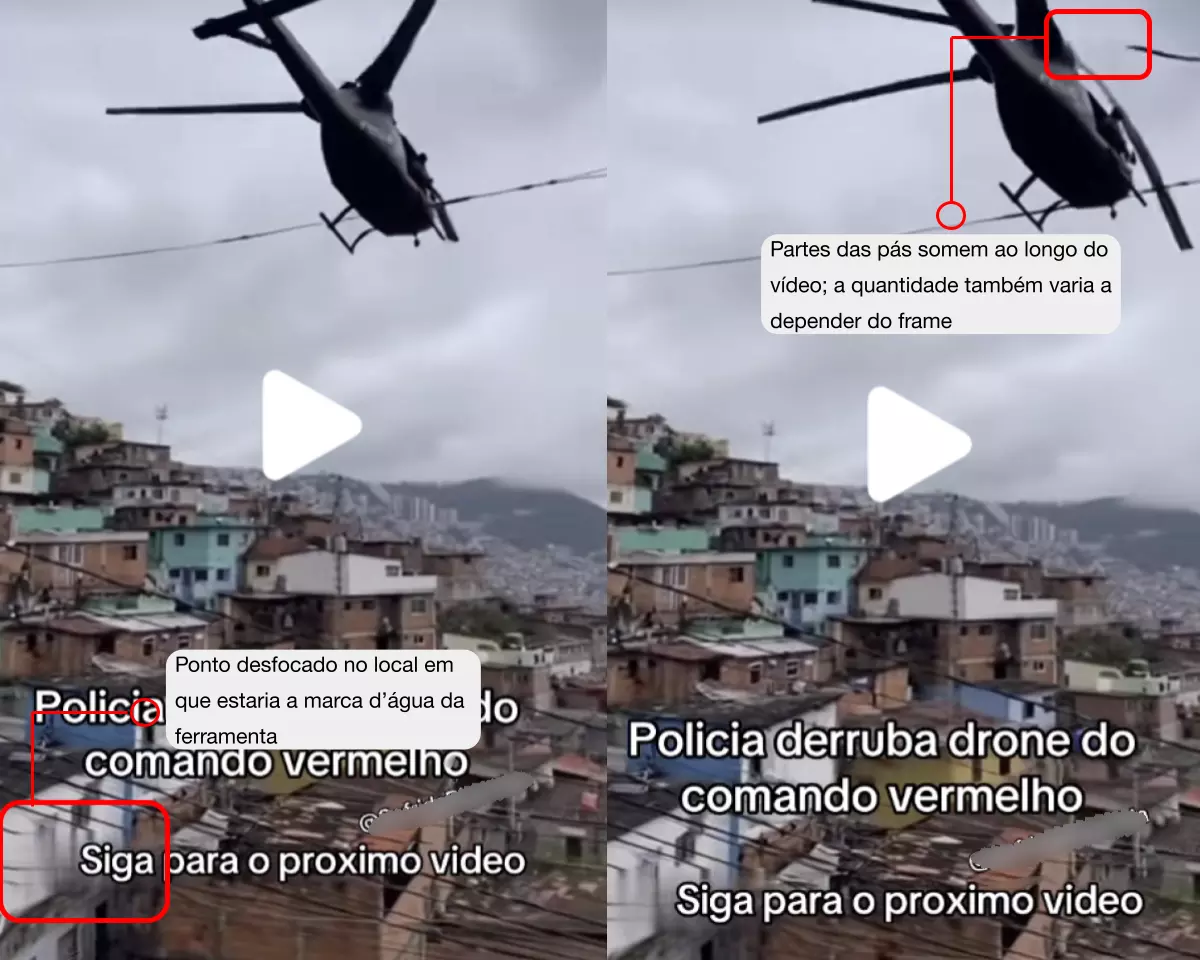

Uno de los videos artificiales, por ejemplo, muestra el supuesto momento en que un helicóptero de las fuerzas de seguridad derriba un dron del Comando Vermelho. Si bien el crimen organizado efectivamente usó drones adaptados para lanzar explosivos contra la policía, la grabación es falsa.

En este caso, aunque los autores de las publicaciones borraron la marca de agua que identificaba el contenido como generado por la herramienta, fue posible detectarlo por varias pistas comunes en imágenes creadas con IA:

- El tamaño de la marca de agua borrada y su desplazamiento en pantalla, típicos de Sora 2.

- La duración del video, que coincide con el límite de la versión gratuita (hasta 10 segundos).

- El hiperrealismo de las imágenes, característico de la herramienta.

- Otros rasgos de imágenes sintéticas, como errores de proporción o texturas plastificadas.

Otros casos de desinformación

Además de los videos sobre la operación en Río, Sora 2 también se usa para producir piezas que retoman desinformaciones ya conocidas.

Uno de los contenidos identificados por Aos Fatos muestra un supuesto diálogo entre un ladrón y un policía. En el video, el delincuente afirma haber robado un celular para “tomar una cervecita” y dice que recibió autorización del presidente Lula Da Silva para cometer el delito.

El contenido hace referencia a una desinformación frecuente asociada al presidente: un video editado que mezcla y descontextualiza fragmentos de una entrevista de 2017 para hacer creer que Lula habría respaldado robos.

Banalización y efecto cotidiano

La mayoría de los videos del relevamiento muestran animales que hablan o escenas deportivas. Aunque parezcan inofensivos, especialistas alertan que la popularización de estos contenidos generados por IA crea un entorno difícil de navegar.

Rogério Christofoletti, profesor de periodismo de la Universidad Federal de Santa Catarina (UFSC), ve con preocupación el avance de herramientas como Sora 2. Sostiene que cuanto más realistas se vuelven estos videos, más se parecen al repertorio visual que acumulamos a lo largo de la vida, lo que nos confunde.

“Si repiten patrones que tenemos incorporados como verdaderos, empiezan a convencernos de que pertenecen a nuestro mismo conjunto de memorias. En otras palabras, nos confundimos”, explicó el investigador.

Para él, esa confusión es peligrosa porque afecta nuestros juicios y acciones: las personas pueden ser engañadas o sufrir daños creyendo que contenidos sintéticos son reales.

Por otro lado, investigadores señalan que el contacto frecuente con videos artificiales puede estimular el pensamiento crítico del público. Un estudio con adolescentes estadounidenses mostró que el 72% cambió la forma de evaluar la información online después de tener contacto con contenido falso o engañoso —generado por IA o no—.

Para Athus Cavalini, doctorando en computación y profesor del Instituto Federal de Espírito Santo (IFES), el contacto con publicaciones más banales es clave para desarrollar este criterio.

“La desinformación en contextos serios y polarizados tiene un fuerte componente emocional. Muchas veces la gente cree algo porque quiere creerlo. En situaciones más triviales, las personas se abren más a cuestionar si algo fue creado por IA”, explicó.

Lucas Bragança, doctor en comunicación por la Universidad Federal Fluminense (UFF), subraya que las tecnologías avanzan rápido y todavía no hay una solución para su impacto sobre la integridad de la información.

Aun así, considera posible cultivar una “cultura de desconfianza saludable”, porque el público tendrá que evaluar con más cuidado antes de creer una información.

Transparencia

Aunque Sora 2 y otras herramientas incluyen marcas de agua en los contenidos generados, muchos creadores eligen remover u ocultar esas señales, dificultando la identificación del origen.

Usuarios más habilidosos también pueden emplear otras tácticas, como comprimir intencionalmente la imagen para esconder imperfecciones o agregar ruido para simular videos amateurs.

Cavalini explica que desarrollar técnicas para detectar uso de IA es complejo. Las propuestas más avanzadas incluyen marcas de agua invisibles, como firmas digitales.

Eso permitiría que plataformas y herramientas trabajaran juntas para etiquetar contenidos de manera automática. Hoy, en la mayoría de los casos, la identificación depende de la decisión del creador.

“Existen medios técnicos para insertar firmas digitales y garantizar la trazabilidad del contenido. Pero hay un problema: la firma tiene que ser abierta para que las redes sociales puedan usarla”, argumenta Cavalini.

Para Bragança, es importante iniciar un debate sobre la regulación de la identificación del uso de IA, porque no es posible frenar el avance de estas tecnologías. Será cada vez más difícil distinguir un contenido sintético solo con la vista humana y no se puede confiar únicamente en la buena voluntad de las big tech para garantizar responsabilidad.

Christofoletti sostiene que es necesario avanzar hacia protocolos y estándares de transparencia en un marco regulatorio multisectorial, democrático y público. Las reglas, afirma, no deben ser definidas solo por el Estado: deben incluir a la academia, la sociedad y las empresas.

“Son desafíos enormes, sí. Pero estas empresas están acostumbradas a crear maravillas. ¿Por qué no ayudarían a construir un futuro más transparente y ético para todos?”, cuestiona.

El otro lado

Aos Fatos contactó a OpenAI y TikTok para comentar el relevamiento. En una nota, la dueña de Sora 2 afirmó que la herramienta fue desarrollada para ampliar el acceso a recursos de creación audiovisual basados en IA y que su lanzamiento priorizó una implementación responsable.

OpenAI destacó que el modelo incluye medidas de seguridad para reducir usos indebidos, como restricciones para crear imágenes de personas reales sin consentimiento, marcas de agua obligatorias y metadatos C2PA en todos los videos generados, además de sistemas de detección y trazabilidad.

Según la empresa, estas acciones integran un compromiso continuo con la transparencia y la seguridad, que también incluye reglas que prohíben engañar usuarios mediante suplantación o fraude. Las infracciones, agregó, pueden derivar en remoción de contenido o sanciones en la plataforma.

TikTok, por su parte, envió un enlace a sus directrices de integridad y autenticidad, que prohíben la publicación de contenidos manipulados con el fin de engañar al público “sobre asuntos de importancia pública o perjudiciales para las personas”, y exigen que los creadores etiqueten contenidos “que muestren escenas o personas con apariencia realista”.

Según la plataforma, los contenidos no etiquetados pueden ser removidos, restringidos o marcados por el equipo de TikTok, “dependiendo del daño que puedan causar”.

La compañía también informó que analizó el relevamiento de Aos Fatos y eliminó los contenidos violatorios. Además, reforzó que TikTok publica trimestralmente informes de moderación y que, según el último reporte, 97% de los videos que violaron las políticas de Integridad y Autenticidad fueron removidos de forma proactiva, y 86% de ellos antes de que tuvieran cualquier visualización.

La plataforma sostuvo que su abordaje “combina tecnología con revisión humana para identificar y remover materiales que puedan violar las Directrices de la Comunidad”, con un equipo “de más de 40.000 profesionales dedicados a la seguridad, incluidos moderadores brasileños”.

Esta nota fue publicada originalmente en el medio Aos Fatos.

Fecha de publicación original: 22/11/2025

Comentarios

Valoramos mucho la opinión de nuestra comunidad de lectores y siempre estamos a favor del debate y del intercambio. Por eso es importante para nosotros generar un espacio de respeto y cuidado, por lo que por favor tené en cuenta que no publicaremos comentarios con insultos, agresiones o mensajes de odio, desinformaciones que pudieran resultar peligrosas para otros, información personal, o promoción o venta de productos.

Muchas gracias