Viaje a la mente de un anticiencia

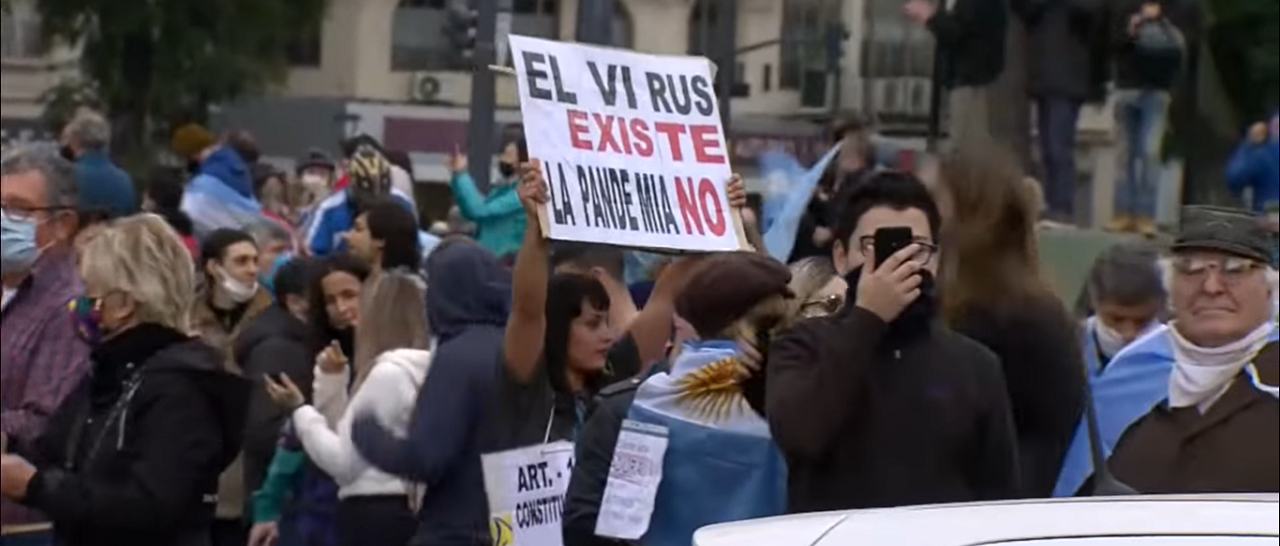

- La pandemia de coronavirus generó un montón de nuevas discusiones, pero hay una que ya viene dándose desde hace años o siglos: cómo luchar contra las creencias anticientíficas.

- Muchas personas se niegan a aceptar información y datos objetivos que son contrarios a sus ideas previas.

- Refutar a los negacionistas de la ciencia no va a hacer que cambien su opinión, pero sí puede ayudar a que personas menos extremas modifiquen sus creencias sobre temas muy importantes como la vacunación.

¿Team invierno o team verano? ¿Queso y dulce de membrillo o de batata? ¿La playa o la montaña?

—No puedo creer que no pienses lo mismo que yo. Estoy dispuesto a perder horas y horas argumentando por qué las medialunas de grasa son superiores a las de manteca, o que las vacunas son un gran adelanto para la humanidad.

—Pará: ¿la BCG al lado de las medialunas de grasa? ¿Es lo mismo discutir sobre facturas que sobre vacunas?

Cuando debatimos sobre nuestros gustos, lo hacemos sabiendo que habrá otras posiciones y que, por más íntima que sean nuestra convicción, es un juicio subjetivo sobre el cual no hay consenso social. En el peor de los casos, vos tomás mate amargo, yo tomo mate dulce, y está todo bien.

En cambio, hace falta mucha confianza en uno mismo para negar la validez de conocimientos compartidos, respaldados por toda una comunidad y sus instituciones. Mucha confianza… tal vez, demasiada.

A veces la confianza es el problema

Hay personas que siempre consideran que saben. No importa el tema: el punto de cocción del merengue, cómo bajar la inflación en Argentina o por qué las tostadas caen siempre con el dulce para abajo. Para tratar de entender cómo piensan estas personas, y si realmente saben tanto, dos científicos norteamericanos, Justin Kruger y David Dunning, hicieron una serie de experimentos.

El objetivo de estos experimentos era descubrir qué tan conscientes somos de lo que sabemos y lo que ignoramos, porque un exceso de confianza en conocimientos equivocados puede llegar, en algunos casos, a ser fatal.

Primero evaluaron la comicidad; o sea, hicieron un listado de 30 chistes y pidieron a humoristas profesionales que les asignaran un puntaje de 0 a 11, donde 0 era “nada gracioso” y 11 era “el chiste más gracioso del mundo”. Luego pidieron la misma tarea a un grupo de estudiantes universitarios que, después de calificar todos los chistes, debían indicar si consideraban que eran mejores o peores que el resto de los estudiantes de la universidad en reconocer si un chiste era gracioso, ubicándose en una escala de 0 (soy el peor) a 99 (soy el mejor).

Como era de esperarse, los participantes sobreestimaron su habilidad: se calificaron con 66, mientras que sus evaluaciones de comicidad habían sido del 50%. Por el contrario, quienes se calificaron más abajo (58) fueron quienes mejor se desempeñaron en la evaluación real.

Lo mismo pasó con otros experimentos, en los que evaluaron capacidades de razonamiento lógico, de gramática, etc. En todos los casos, los participantes sobreestimaron cuántas preguntas habían contestado bien, especialmente quienes peor desempeño habían tenido: se habían sacado un 12 (real), pero se auto-percibieron con un 68.

Dicho en otros términos: los peores en la clasificación de los chistes fueron los que se percibieron como mejores para esa tarea. Este efecto parecía asociado a algo más general, como la capacidad de reconocer la propia incompetencia. Esta habilidad (de evaluar lo que sabemos y lo que no sabemos) se conoce como metacognición.

Para evaluar la metacognición, decidieron mostrarle a todos los estudiantes las respuestas de los demás, y pedirles que volvieran a revisar sus propias respuestas. ¿El resultado? Los que tuvieron un peor desempeño, pero creían que les había ido súper bien, no cambiaron sus resultados, y siguieron tan equivocados como antes. Por el contrario, los que consideraron que no lo habían hecho tan bien -aunque, en términos reales, sí lo habían hecho- se mostraron abiertos a cambiar sus respuestas y, así, mejorar todavía más sus resultados.

Este efecto (llamado “efecto Dunning-Kruger”, por los autores del artículo) explica por qué muchas personas se niegan a aceptar información y datos objetivos que son contrarios a sus ideas previas: las personas más equivocadas son las que más confían en sus propias creencias, y las que menos aceptan como válida la información contraria.

Cuidado con los extremos

La mayoría de las personas somos más críticas con la información que nos contradice que con la información que nos apoya. Si me gusta tomar vino tinto, voy a estar de acuerdo y a compartir con mis amigos las notas que digan que hace bien al corazón. En cambio, voy a ser más desconfiado con los artículos que dicen que hace mal, aún en pequeñas cantidades. Esta actitud se denomina “escepticismo motivado”: somos más críticos y analizamos con más detalle a quienes no piensan como nosotros.

Esto genera un problema: si voy a aceptar sin mucha discusión lo que dicen quienes piensan como yo, y voy a cuestionar hasta el menor detalle a quienes no piensan como yo, cambiar de opinión, aún cuando haya evidencia, se vuelve más difícil. Especialmente cuanto más radicalizadas sean nuestras opiniones.

Tres investigadores británicos -Max Rollwage, Raymond Dolan y Stephen Fleming- hicieron una serie de experimentos sobre ideas políticas e intolerancia (a las ideas ajenas y resistencia al cambio de creencias) y descubrieron que, sin importar si eran de izquierda o de derecha, quienes estaban en los extremos eran más intolerantes. O sea: la intolerancia al pensamiento de los demás es mayor cuando más radical, o polarizada, es la creencia de una persona.

Además, evaluaron la metacognición, es decir, la capacidad que tenemos de analizar y evaluar lo que sabemos. Para eso, se hizo un experimento en el que una pantalla mostraba dos manchas con puntos titilantes, y se pedía que los participantes indicaran en cuál había más puntos. Una vez seleccionada, debían indicar qué tan confiados estaban en que su decisión era correcta en una escala del 1 al 10.

El estudio mostró que las personas más radicalizadas en sus ideas políticas -y, como vimos antes, más intolerantes y rígidas en sus creencias- fueron las que peor evaluaron sus decisiones. En otras palabras: mostraron una menor capacidad de diferenciar decisiones correctas de incorrectas en todos los ámbitos, no solamente en el político.

Un dato interesante fue que las personas de distinto grado de radicalización tuvieron un desempeño parecido en la prueba (71% de aciertos), aunque las más radicalizadas estimaron -erróneamente- que su desempeño había sido mejor.

¿Y qué pasa si incorporamos nueva información? Para responder esta pregunta, al experimento anterior se le agregó otro momento: después de elegir qué mancha tenía más luces titilantes, se presentaba la misma mancha, pero exagerada. La idea era que, si tu decisión había sido correcta, la nueva evidencia aumentaría tu confianza; y, al contrario, si tu decisión había sido incorrecta, la nueva evidencia debía disminuir la confianza en ella.

Los resultados, sin embargo, mostraron que las personas más dogmáticas e intolerantes eran menos receptivas a la nueva información. O sea: aunque les guiñaron un ojo, les pisaron el pie y les gritaron “incorrecto”, los más radicalizados seguían igual de confiados en que habían tomado la decisión correcta.

Este modo de razonar, que se encuentra en ideas conspirativas y anticientíficas, parece estar basado en un tipo de pensamiento más intuitivo, en contraposición al pensamiento más reflexivo. Es decir, un mayor monitoreo de los pensamientos (pensamiento reflexivo) permite una menor creencia en teorías conspirativas. En otras palabras: las personas más reflexivas y con mejor metacognición son capaces de distanciarse de sus propias ideas, examinarlas y evaluar mejor su propio conocimiento y comportamiento.

Estos experimentos mostraron algo muy importante: la intolerancia política es indicadora de una menor capacidad de pensamiento crítico -y menor disposición a cambiar de creencias- en todos los campos de la cognición.

La grieta y las ideas científicas

¿Pasa lo mismo con las creencias anticientíficas? La verdad que sí.

En un trabajo publicado en la revista Nature Human Behavior, por ejemplo, se evaluó la relación entre la percepción subjetiva de conocimiento sobre alimentos genéticamente modificados, el conocimiento real que los participantes tenían sobre el tema, y el nivel de oposición al consumo de alimentos modificados genéticamente.

Por un lado observaron que a medida que hay más oposición a este tipo de alimentos, el conocimiento objetivo es menor. O sea, las personas que más se opusieron, objetivamente tenían menos conocimiento científico.

Lo más interesante fue que para los participantes que más se oponían a los alimentos genéticamente modificados, su percepción de conocimiento científico era mucho mayor a su conocimiento objetivo. Es el efecto Dunning-Kruger, otra vez: cuanto menos conocimiento científico sobre el tema tenían, más se oponían y más creían que sabían.

Esto permite relacionar la incapacidad de reconocer la incompetencia sobre un determinado tema con actitudes anticientíficas, pero también con actitudes radicalizadas en otros ámbitos de la vida. Las habilidades metacognitivas son independientes del tipo de decisión que se esté tomando y por lo tanto, podría ser un rasgo inherente a la persona.

Si uno evalúa que sus decisiones son siempre las mejores, entonces será más difícil aceptar que uno está equivocado, y eso vale tanto para votar en las elecciones como para aceptar ponerse una vacuna para la COVID-19.

Entonces: ¿vale la pena discutir con una persona anticiencia?

¿Para qué escribimos esta nota, entonces? Si vos creés en el conocimiento científico, no hace falta que tratemos de convencerte. Si vos no creés, igual no te vamos a convencer.

Muchas veces se argumenta que es un problema de información: que si diéramos suficiente evidencia, y la comunicáramos bien, nadie creería en conocimientos falsos. Podríamos así erradicar ideas falsas sobre las vacunas y el autismo, sobre la forma de la tierra (no, no es plana), etc. Sin embargo, la evidencia científica muestra que el sesgo anticientífico no se produce por falta de información.

En un estudio sobre actitudes hacia el cambio climático, por ejemplo, se observó que personas con altos niveles de conocimiento científico tenían posturas opuestas acerca del tema. Estos resultados no se explican por la falta de información -porque era gente muy informada- sino por un conflicto entre el interés personal (formar creencias en línea con sus amigos, instituciones o personas cercanas) y el interés colectivo por el futuro del planeta.

Y, puestos en ese conflicto, ganan las emociones: el efecto de familiaridad y el sesgo de confirmación, que nos llevan a aceptar como válida sólo la información que confirma nuestras ideas previas.

Un trabajo muy detallado sobre las maneras de argumentar de las personas anticientíficas mostró que no responder a los negadores de la ciencia tiene un efecto negativo hacia los comportamientos basados en la evidencia. O sea: no tenemos que quedarnos callados cuando una conductora de televisión toma dióxido de cloro en cámara, porque de esa manera ayudamos a difundir actitudes anticientíficas.

Explicar la evidencia existente y mostrar los errores de razonamiento de los negacionistas tiene efectos positivos. Incluso en el debate público (medios de comunicación o redes sociales) la refutación es positiva en todos los casos. Además, dado que los negacionistas científicos usan la misma retórica en todos los dominios, descubrir sus técnicas retóricas es clave para llevar el debate a todos los ámbitos.

Por lo que vimos más arriba, está claro que el debate no va a llevar a que las personas más radicalizadas cambien su opinión. Sin embargo, al refutar a los negacionistas desarmando la lógica de sus dichos, ayudamos a la audiencia menos extrema -y, probablemente, mayoritaria- a cambiar las creencias, por ejemplo acerca de la vacunación.

Así que: ¡a no desanimarse! Vale la pena discutir, debatir y reflexionar para combatir la desinformación y el pensamiento anticientífico, siempre con información chequeada y de calidad. Aunque no cambien las posturas de las personas más radicalizadas, siempre habrá gente con dudas, esperando recibir #InfoDeLaBuena.

Si querés estar mejor informado sobre la pandemia, entrá al Especial Coronavirus.

Fecha de publicación original: 26/05/2021

Comentarios

Valoramos mucho la opinión de nuestra comunidad de lectores y siempre estamos a favor del debate y del intercambio. Por eso es importante para nosotros generar un espacio de respeto y cuidado, por lo que por favor tené en cuenta que no publicaremos comentarios con insultos, agresiones o mensajes de odio, desinformaciones que pudieran resultar peligrosas para otros, información personal, o promoción o venta de productos.

Muchas gracias