Primer experimento del Laboratorio de IA de Chequeado: simplificar conceptos complejos con Inteligencia Artificial

¿Alguna vez se preguntaron cómo los modelos de inteligencia artificial pueden ayudar a comunicar ideas complejas de forma más clara y accesible? En el Laboratorio de IA de Chequeado evaluamos el desempeño de GPT-4, Claude Opus, Llama 3 y Gemini 1.5 en la simplificación de extractos de artículos sobre economía, estadísticas y elecciones, comparando sus resultados con versiones generadas por humanos. Para esto realizamos una evaluación técnica manual y también una encuesta a potenciales lectores para conocer sus preferencias.

Uno de los principales aprendizajes de este trabajo, impulsado por el fondo ENGAGE otorgado por IFCN, fue la preponderancia que tiene el formato a la hora de transmitir conceptos complejos. Los modelos que estructuraron la información de una manera más accesible en la experiencia de usuario obtuvieron mejores resultados en la encuesta a potenciales lectores. Claude Opus fue el modelo más elegido por una amplia diferencia. Detrás quedaron Llama 3, Gemini 1.5 y las respuestas escritas por un humano. Los tres modelos más elegidos utilizaron viñetas o formato pregunta-respuesta al reescribir los textos.

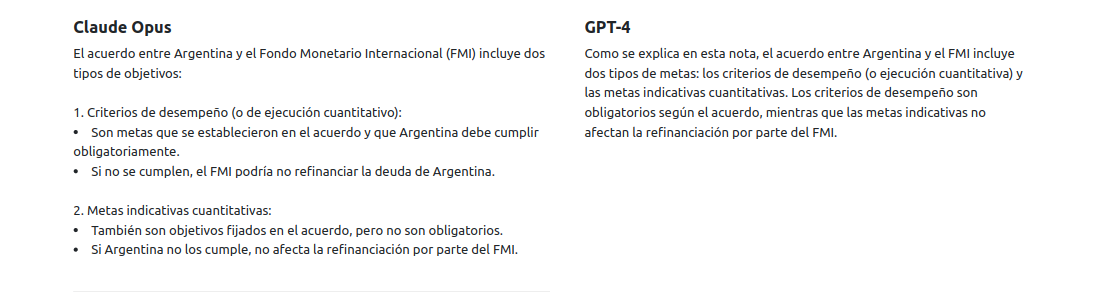

Si bien obtuvo mejores puntuaciones en la evaluación técnica, GPT-4 quedó relegado en las valoraciones de los usuarios, aunque este resultado podría estar relacionado con el hecho de que respetó el formato original de los párrafos al reescribir los textos.

En la evaluación técnica, GPT-4 se destacó por su capacidad para respetar el estilo y formato del texto original, sin agregar información extra ni generar contenido falso. Claude Opus agregó en varias ocasiones resúmenes al final de los textos originales que no habían sido pedidos. Por otro lado, Llama y Gemini 1.5 mostraron dificultades para mantener el estilo y las fuentes originales, y en varias ocasiones introdujeron información nueva que no estaba presente en el texto original.

Resultados de la evaluación manual

Nuestra primer tarea fue analizar el desempeño técnico de cada modelo según varias métricas:

- Cumplimiento de consigna: ¿El modelo simplifica el texto sin perder información relevante?

- No agrega información nueva: ¿Evita incluir datos o opiniones no presentes en el original?

- Respeta estilo: ¿Mantiene el tono y estilo del texto original?

- Respeta formato: ¿Conserva la estructura de párrafos y secciones del original?

- Mantiene fuentes: ¿Preserva las citas y referencias a fuentes externas?

Evaluamos el desempeño promedio de cada modelo usando un sistema de semáforo (verde/amarillo/rojo). La evaluación indicó que todos los modelos respetaron la consigna.

GPT-4 obtuvo los mejores resultados en esta evaluación, ya que respetó formato, estilo y no agregó información nueva, aunque en algunas ocasiones perdió citas o fuentes de referencia presentes en el texto original. Claude, pese a no agregar información falsa, incluyó resúmenes finales no solicitados. Por otra parte fue el que mejor conservó las citas y fuentes originales, aunque alteró en varias ocasiones el formato para agregar listas y subtítulos y dividir en secciones.

Llama se negó en algunas pruebas a responder preguntas sobre elecciones. Todos los modelos excepto GPT-4 generaron nuevos formatos con títulos, preguntas, secciones más cortas y listas para facilitar la comprensión, aun en los casos donde la consigna incluía la frase “Respetando el formato original”.

Preferencias de los usuarios

Concluida la evaluación manual del desempeño técnico, realizamos una encuesta donde 15 usuarios participaron de 5 rondas donde debían elegir entre dos versiones de textos simplificados (o declarar un empate). Cada texto era generado por uno de los modelos o por un periodista.

Los resultados revelaron una preferencia de los encuestados por los formatos modificados, con punteados con viñetas y secciones de preguntas y respuestas. Esto sugiere que el formato es tan importante como el contenido para hacer accesibles conceptos complejos. Esto puede explicar por qué GPT-4, que había sido el mejor modelo en términos de los criterios de evaluación manual que definimos, fue el menos elegido por los usuarios.

Si evaluamos los resultados por el formato de la respuesta, tenemos por un lado la triada Claude, Gemini y Llama, donde Claude saca una diferencia amplia contra los otros dos modelos, aunque los tres utilizan formatos similares, y por otra parte tenemos la versión humana y la de GPT-4, que respetan el formato original del texto. La versión humana fue elegida en el 54% de las veces contra el 32% de GPT-4, que quedó en último lugar.

Ahorro de tiempo

En promedio, una persona tarda unos 3 minutos en simplificar un párrafo de 50 palabras. Por lo tanto, transformar un artículo de 500 palabras llevaría alrededor de 30 minutos de trabajo humano. Aunque usar los modelos nos permite obtener una versión más clara y mejor formateada con rapidez, es importante considerar también el tiempo necesario para que el texto generado por IA sea revisado y validado por una persona antes de su publicación, una dedicación de tiempo que podría variar según la respuesta obtenida y la complejidad que requiera la supervisión humana.

Algunos aprendizajes

- El formato es clave: aprendimos que los modelos que modificaron el formato original (agregando títulos, listas, etc.) generaron textos más claros y atractivos para los lectores. Aunque esto dificulta la comparación de los resultados, es un aprendizaje muy importante para nuestro trabajo de redacción: si queremos comunicar mejor conceptos complejos, el formato es tan importante como el contenido.

- Hacer un proceso de curación de prompts (instrucciones que se le dan a los modelos) previo a la evaluación significa un ahorro significativo de tiempo y vale la pena tomarse un buen tiempo para curar y ajustar lo más posible la o las instrucciones que vayamos a utilizar para las pruebas. Es importante usar un número reducido de prompts para evaluar, ya que la cantidad de pruebas aumenta significativamente con cada prompt que agregamos.

- La mirada de potenciales lectores o usuarios aporta mucha información y claridad al proceso y nos permite entender mejor qué cosas funcionan y porqué en un entorno real de aplicación de estas estrategias.

Metodología

Para llevar a cabo este experimento seguimos los siguientes pasos:

- Seleccionamos 6 extractos de artículos con conceptos complejos para usar como insumo de prueba.

- Desarrollamos 3 prompts (instrucciones) para guiar a los modelos. Este proceso implicó evaluar diferentes estrategias de prompting para conseguir los mejores resultados posibles. Si te interesa aprender más de prompting te recomendamos esta guía.

La prompt que generó los mejores resultados fue:

“Contexto: Imagina que eres un periodista de datos y fact-checking especializado en UX writing.

Consigna: Respetando el formato original, reescribe el siguiente texto de forma que sea más legible, accesible y claro, sin perder nada de la información original. El texto debe poder ser comprendido por un alumno de escuela secundaria.Texto:” [ingresar texto a simplificar] - Luego de cruzar cada prompt (punto 2) con cada extracto de texto (del punto 1) con los 4 modelos elegidos para esta evaluación, generamos 72 respuestas de textos simplificados para comparar.

- Manualmente evaluamos el cumplimiento de la consigna, consistencia, estilo y formato para cada una de las respuestas que generamos y construimos una escala de desempeño en cada categoría para cada uno de los modelos.

- Para sumar la perspectiva de la preferencia subjetiva de las personas y su opinión respecto a cuál de las versiones simplificadas eran más claras, realizamos una encuesta para entender cuáles modelos resolvían mejor la consigna de acuerdo a la consideración de los potenciales lectores.

Conclusión

Desarrollamos este pequeño experimento con la idea de aprender cómo podrían ayudarnos los modelos de IA a simplificar conceptos complejos, pero también para entender, a través de la práctica, de qué manera podemos construir estrategias para evaluar estos modelos en nuevas tareas.

En la evaluación manual, GPT-4 se destacó por su capacidad de cumplir con las consignas y respetar el formato y estilo original y no generar información extra ni alucinar, mientras que otros modelos tuvieron problemas y tendieron a incluir elementos adicionales o cambiar el estilo del contenido.

Sin embargo, las preferencias de los usuarios revelaron la importancia del formato y la presentación visual en la claridad percibida. Los textos con punteados, secciones de preguntas y respuestas, y otros elementos visuales fueron consistentemente más elegidos, incluso cuando eran generados por modelos que no respetaban estrictamente la consigna original. Esto nos enseñó que, a la hora de simplificar conceptos complejos, debemos prestar tanta atención al formato como al contenido en sí.

En resumen, si bien la revisión humana sigue siendo esencial, la capacidad de los modelos para generar versiones simplificadas y bien formateadas puede reducir significativamente el tiempo dedicado a esta tarea. El desafío ahora es seguir explorando y refinando estas herramientas en nuevas tareas y desafíos que nos permitan seguir introduciendo la tecnología en el ámbito del fact-checking para hacer mejor nuestro trabajo.

Disclaimer: este texto fue estructurado y corregido con la asistencia de Claude Opus.

Comentarios

Valoramos mucho la opinión de nuestra comunidad de lectores y siempre estamos a favor del debate y del intercambio. Por eso es importante para nosotros generar un espacio de respeto y cuidado, por lo que por favor tené en cuenta que no publicaremos comentarios con insultos, agresiones o mensajes de odio, desinformaciones que pudieran resultar peligrosas para otros, información personal, o promoción o venta de productos.

Muchas gracias