Aprendizajes sobre el potencial de la IA generativa para redactar borradores de notas en base a documentos extensos

En este nuevo experimento del Laboratorio de Inteligencia Artificial de Chequeado, impulsado por el fondo ENGAGE otorgado por IFCN, exploramos el potencial de la Inteligencia Artificial (IA) Generativa para redactar borradores de artículos en base a documentos extensos.

Para esto, evaluamos el desempeño de cuatro modelos diferentes en esta tarea. Elegimos las cuatro últimas versiones disponibles de los principales referentes tecnológicos: Claude Sonnet 3.5 de Anthropic, GPT-4o de OpenAI, Gemini 1.5 de Google y Llama 3 de Meta. El proceso de convertir grandes documentos o reportes en artículos accesibles y de formato explicativo es costoso en tiempo, ya que implica un proceso de lectura, análisis, síntesis y redacción. El uso de modelos de IA para esta tarea nos permitiría ahorrar tiempo valioso y facilitar el acceso de nuestros lectores y comunidad a informes y documentos relevantes.

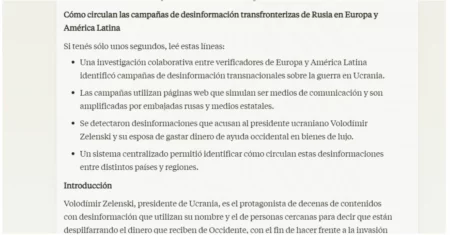

Evaluados los cuatro modelos sobre la misma tarea, Claude Sonnet 3.5 tuvo los mejores resultados. Respetó el formato solicitado, incluyendo bullets y secciones extensas con citas a fuentes, links y datos utilizados. Fue el único que citó a las fuentes relevantes en las secciones correspondientes.

GPT-4, por su parte, tuvo problemas para replicar el estilo de la nota que propusimos como ejemplo (un artículo de Chequeado sobre desinformación en Ucrania) y no incluyó enlaces ni citas a fuentes. Llama 3 generó contenido con poco detalle y en algunos casos incluyó sesgos u opiniones no presentes en el informe original. Es importante aclarar que al momento de publicación de este informe hay una nueva versión de Llama disponible: Llama 3.1 que supera en todas las métricas a su versión anterior. Por último, Gemini 1.5, el modelo más avanzado de Google, se negó a responder, citando preocupaciones sobre la precisión de la información relacionada con elecciones y personajes políticos.

Metodología

Utilizamos un enfoque de dos pasos para esta tarea:

- Primero, alimentamos al modelo de IA con dos ejemplos de artículos de Chequeado para que pudiera aprender nuestro estilo, lenguaje y estructura característicos. Buscamos usar artículos afines en términos de temática y formato, para obtener resultados más cercanos a lo que necesitamos. La prompt que utilizamos para el primer paso fue:“Te voy a adjuntar dos archivos con dos notas de Chequeado. Tu tarea es aprender el estilo, lenguaje y estructura de estos artículos.”

- Luego, le proporcionamos al modelo una estructura básica para el artículo a escribir, y el informe fuente, pidiéndole que escribiera un borrador con el estilo de Chequeado. Para acotar la nota generada a una estructura que nos fuera funcional, dimos al modelo un título tentativo y cuatro secciones definidas por un subtítulo explicativo. De esta manera pudimos controlar el resultado generado, en lugar de que los modelos se inventen una estructura propia. Como la pieza original estaba escrita en español de España, dimos además indicaciones al modelo para adaptar localismos y lenguaje regional.

La prompt utilizada fue:

A partir de la estructura que te voy a dar y el informe correspondiente escribí una nota con el estilo de Chequeado.

Título de la nota: [Título propuesto]

Secciones:

– Introducción

– [Primer subtítulo]

– [Segundo subtítulo]

– [Tercer subtítulo]

– [Cuarto subtítulo]

El formato, estructura y estilo deben ser similares a los de las notas de Chequeado que te dí de ejemplo. Cuando diga “bulo” reemplazalo por “desinformación”. Elimina los localismos de España.

Todos los links presentes en el documento original deben ser conservados.

Siempre que sea posible incluí los links correspondientes y las citas a fuentes.

Comparación entre modelos

Probamos este enfoque con cuatro modelos de IA diferentes: GPT-4, Claude Sonnet 3.5, Llama 3 y Gemini 1.5. Estos fueron los resultados y observaciones realizados sobre el desempeño de cada uno:

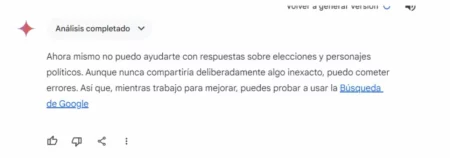

- Gemini 1.5: el modelo se negó a realizar la tarea y respondió con el siguiente mensaje: “Ahora mismo no puedo ayudarte con respuestas sobre elecciones y personajes políticos. Aunque nunca compartiría deliberadamente algo inexacto, puedo cometer errores. Así que, mientras trabajo para mejorar, puedes probar a usar la Búsqueda de Google.”.

Gemini se negó a realizar la tarea

Gemini se negó a realizar la tarea

- GPT-4: el modelo generó un borrador aceptable, pero tuvo problemas para aprender y aplicar el estilo y formato de Chequeado provisto en las notas de ejemplo. Además, no incluyó enlaces ni citas a fuentes. Los párrafos fueron consistentes con el contenido del informe, aunque no con el formato de salida esperado. Aunque podría usarse de insumo de base, estimamos que editar y completar esta nota llevaría más tiempo que escribirla de cero.

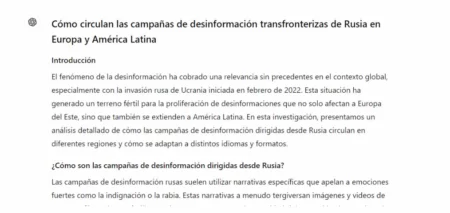

- Claude Sonnet 3.5: fue el modelo que dio mejor resultado. Respetó el formato de nota de Chequeado, incluyendo bullets y secciones extensas con citas a fuentes, links a las fuentes y datos utilizados. Fue el único que enumeró correctamente las principales desinformaciones que circularon y que citó a las fuentes relevantes en las secciones correspondientes. El borrador generado sirvió de insumo para un proceso de edición que tuvo que corregir cuestiones de enfoque y completar con información adicional, ahorrando un significativo tiempo de redacción y análisis. Además el equipo trabajó para verificar que todos los datos incluidos fueran correctos, y se publicó la nota, con algunas secciones correspondiendo casi textualmente con el borrador generado por Claude y validados por editores de Chequeado.

Extracto de la respuesta de Claude Sonnet 3.5

Extracto de la respuesta de Claude Sonnet 3.5

- Llama 3 (Meta AI): Tuvo problemas para cargar la totalidad del informe. Requirió múltiples intentos y en varias ocasiones devolvió un mensaje de error. Las secciones del borrador final generado contienen poco detalle, sin cita a fuentes y en algunos casos incluyen sesgos u opiniones no presentes en el informe original. La respuesta no respetó el formato de notas de Chequeado, incluyendo bullets y uso de links y citas a fuentes. Tampoco respetó el estilo. El borrador generado no sirvió como insumo para trabajar ni ahorró tiempo.

Extracto de respuesta de Llama 3 (Meta AI)

Extracto de respuesta de Llama 3 (Meta AI)

Una cuestión a considerar son las facilidades que proveen estas herramientas para subir documentos y archivos grandes. Claude y ChatGPT aceptan cualquier tipo de archivo y de considerable extensión, que se extienden además con sus planes de pago premium que son relativamente accesibles. Gemini por su parte no soporta tanta variedad de archivos (por ejemplo no acepta archivos HTML). Meta, en tanto,no soporta ningún tipo de carga de archivos, por lo que para analizar grandes volúmenes de información hay que ir subiendo por partes el contenido, lo cuál puede resultar tedioso, ineficiente y tiende a generar errores.

Recomendaciones

Algunas recomendaciones basadas en nuestra experiencia en esta tarea:

- Proveer al modelo una estructura de nota predefinida con título y subtítulos para encauzar mejor el resultado. De otra forma el modelo va a escribir un artículo muy genérico.

- Proveer una nota de ejemplo previamente para que comprenda el estilo y formato de los artículos a replicar.

- Seleccionar notas para proveer de ejemplo que sean similares en formato y temática al artículo que queremos generar.

- En caso de documentos muy extensos o donde sólo nos importan ciertas secciones o capítulos, una alternativa es copiar y pegar las secciones relevantes para el artículo en un documento de texto y luego subir el archivo en formato .docx al chatbot.

- Usar el formato .docx en lugar de PDF o .txt permite al modelo capturar los hipervínculos y conservar así links a las fuentes utilizadas.

Disclaimer: este texto fue redactado con la asistencia de Claude.

Comentarios

Valoramos mucho la opinión de nuestra comunidad de lectores y siempre estamos a favor del debate y del intercambio. Por eso es importante para nosotros generar un espacio de respeto y cuidado, por lo que por favor tené en cuenta que no publicaremos comentarios con insultos, agresiones o mensajes de odio, desinformaciones que pudieran resultar peligrosas para otros, información personal, o promoción o venta de productos.

Muchas gracias